Vom 9. bis 11. November fand wieder eine LAN Party in der Jungen Linde statt. Wir haben beim Aufbau der Infrastruktur geholfen und die Chance genutzt, um diverse neue Dinge zu auszuprobieren.

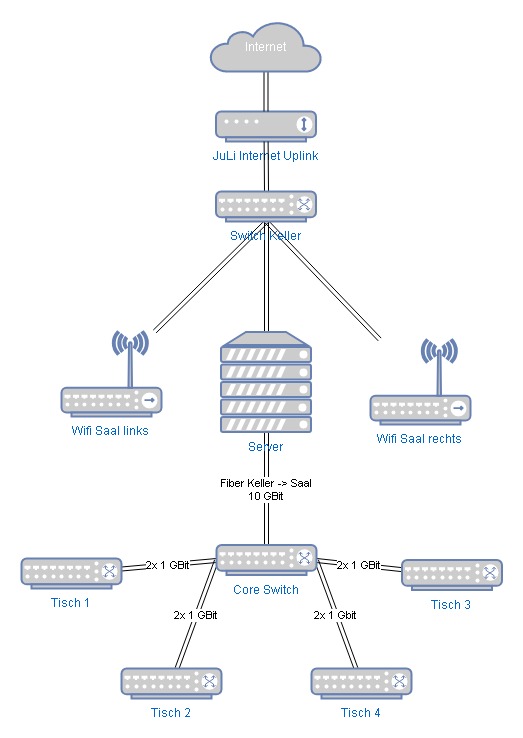

Der Plan

- Für eine stabilere Internetverbindung sorgen

- Für diverse Dienste Caches einrichten

- 10 Gigabit Verbindung vom Core Switch zum Fileserver

- 2x 1 Gigabit zu jedem der Tische

Die Internetverbindung

In der JuLi haben wir extra für die LAN einen eigenen Internetanschluss geschaltet, welcher aber leider nur 20 Megabit pro Sekunde liefert. Mehr ist seitens der Anbieter vor Ort leider nicht drin.

In der JuLi haben wir extra für die LAN einen eigenen Internetanschluss geschaltet, welcher aber leider nur 20 Megabit pro Sekunde liefert. Mehr ist seitens der Anbieter vor Ort leider nicht drin.

Anstatt den Anschluss wie die letzten Male einfach den Teilnehmern „hinzuschmeißen“, wurde dieses Mal mit dem Traffic Shaper Modul von OPNSense gearbeitet.

Der Traffic, welcher aus dem Event-Netzwerk kommt, wird in eine Queue eingereiht welche die Bandbreite gleichmäßig auf die Teilnehmer verteilt. Das sorgt dafür, dass niemand die komplette Bandbreite ausnutzen kann. Jeder kommt mal dran.

Gleichzeitig wird ein kleiner Teil der Bandbreite für den Betrieb des Netzwerkes (zB Monitoring) freigehalten, sodass es bei kompletter Auslastung niemals zu Fehlalarmen (welche OPNSense dazu verleiten können, den Uplink abzuschalten) kommen kann. (Für weitere Infos hier klicken)

Das Internet war immer erreichbar. Auch wenn die Verbindung nicht schnell war, lief sie stabil. Zu keinem Zeitpunkt war die Verbindung so ausgelastet, dass „gar nichts mehr ging“.

Cache all the things!

Ein Mitglied von uns präsentierte vor ein paar Wochen beim Clubtreffen das Steamcache Projekt.

Ein Mitglied von uns präsentierte vor ein paar Wochen beim Clubtreffen das Steamcache Projekt.

Die Software leitet via DNS Override jeglichen Traffic der großen Game Clouds auf einen Proxy Service um. Spiele-Downloads müssen so nur einmal durchgeführt werden und werden anschließend lokal vorgehalten. Alle weiteren Downloads des gleichen Spiels liefen anschließend im Schnitt mit 500 Megabit die Sekunde.

Die Caches und der DNS Server werden als Docker Container installiert. Wir haben uns dafür ein Ansible Playbook gebaut, welches die Installation komplett automatisiert.

Zur Erstellung von Statistiken gibt es in unserem Git noch ein weiteres Projekt, mit dem sich die Access Logs der Caches auswerten lassen.

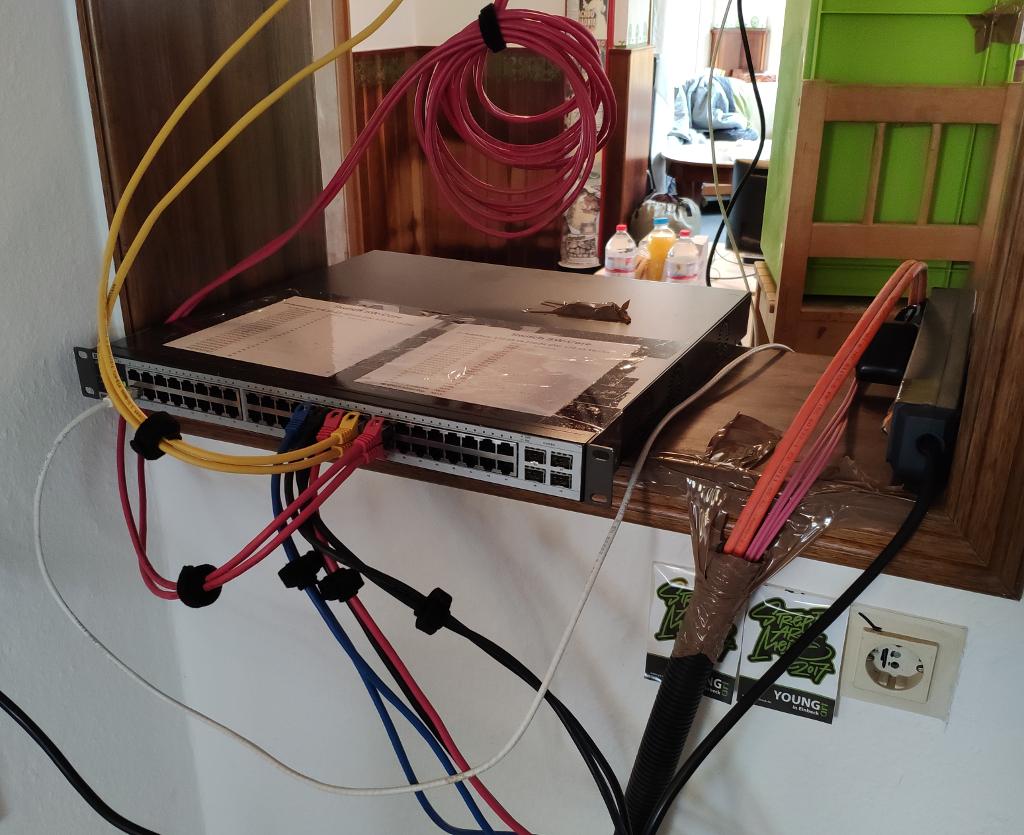

Neue Netzwerkinfrastruktur

Bisher war das Netzwerk ein reines Gigabit Netzwerk. Einfach eine Handvoll Switches, welche mit je einem Kabel miteinander verbunden wurden.

Dieses Mal ist ein wenig mehr Arbeit reingeflossen:

Zwischen Keller und dem großen Saal liegt nun eine Glasfaserleitung, welche uns eine Anbindung des Servers mit bis zu 10 Gigabit pro Sekunde erlaubt. Zwischen dem Core Switch und den Tischen werden zwei normale Patch-Kabel zu 2 Gigabit zusammengefasst.

Zahlen

- Es wurden aus dem Internet insgesamt 402 Gigabyte herunter- und 24 Gigabyte hochgeladen

- Das Saalnetzwerk hat insgesamt 4,5 Terabyte Daten zwischen den einzelnen PCs und Servern verarbeitet

- Durchschnittlich haben die Switche über die zwei Tage eine Bandbreite von 242 Megabit/sek verarbeitet

- Die Peaks lagen auf allen Switches zwischen 500 Megabit und 700 Megabit

- Von den Spiele-Clouds wurden insgesamt 144 Gigabyte heruntergeladen, wovon 31 Gigabyte wiederverwendet werden konnten

Unsere Fehler

Der Start war echt anstrengend. Wir haben den Aufwand beim Aufbau des Netzes unterschätzt und viel zu spät angefangen.

So wurde auf zwei Switches die Konfiguration nicht gespeichert, was erst bei Inbetriebnahme aufgefallen ist. Auch hatten wir bei der Anbindung im Keller einen groben Denkfehler gemacht, welcher den Start der LAN stark verzögert hat.

Wirklich starten konnte die LAN dann mit zirka drei Stunden Verspätung. In der ersten Nacht fiel dann noch ein Konfigurationsfehler auf. Immer wieder wurden einzelne Teilnehmer oder ganze Switche vom Netzwerk getrennt.

Ursachen der Probleme:

- Es war nicht auf allen Switches Flow Control eingeschaltet

- Der LCAP Algorithmus war nicht auf allen Swichtes auf „SRC+DST MAC Address“ eingestellt

Zu guter Letzt hatten einige Teilnehmer Probleme den Fileserver via Samba zu erreichen. Es erschien eine Kennwort Abfrage, obwohl die Freigabe mit Gast-Zugriff konfiguriert war. Hier fehlte die Anweisung „guest ok = yes“ in der „[global]“ Section.

Nächstes Mal…

haben wir eventuell noch einen zweiten 10 Gigabit Switch, sodass wir nicht mehr den kompletten Traffic durch den Server schleifen müssen. Das sollte die Anbindung des Servers noch einmal ordentlich verbessern.

Ansonsten versuchen™ wir nächstes Mal früher mit dem Aufbau zu starten, sodass wir Zeit fürs Testen haben.